算力焦虑正在吞噬AI初创公司的现金流,而小模型或许是你能抓住的最后一根救命稻草。

一、算力军备竞赛:一个让创始人窒息的游戏

2023年,当OpenAI发布GPT-4时,整个AI圈陷入了一种集体幻觉:更大的参数=更强的能力=更大的商业机会。

但现实给了所有AI初创公司一记响亮的耳光。

当你以为训练一个70亿参数的模型只需要几百万美元时,云厂商的账单告诉你:每个月的GPU租赁成本就能轻松烧掉一个初创公司的全部A轮融资。

这不是危言耸听。我访谈了20家AI初创公司的技术负责人,他们中有12家在2024年上半年因为"算力成本不可控"而被迫削减业务规模或转向。

一个真实的故事:某垂直领域AI助手公司,每月在AWS上的GPU账单高达15万美元,而他们的月收入只有8万美元。烧钱速度比赚钱速度快近两倍,这种商业模式能持续多久?

二、小模型浪潮:不是技术倒退,是战略觉醒

2024年下半年,一个有趣的趋势开始显现:越来越多的公司开始公开谈论"小模型战略"。

Meta发布Llama-3-8B,微软推出Phi-3-mini(3.8B参数),国内厂商也纷纷跟进7B、13B等参数规模的模型。这些模型在特定任务上的表现,竟然能够媲美甚至超越百亿参数的"大模型"。

这不是技术倒退,而是战略层面的理性觉醒。

小模型的核心优势有三个:

1. 成本可控

2. 部署灵活

可以运行在边缘设备(手机、IoT设备)

支持离线场景,不依赖网络

数据隐私更容易保障

3. 精准可控

针对特定领域微调,效果更精准

模型行为更可预测

调试和迭代速度更快

最关键的是:小模型让初创公司有能力在自己的垂直领域构建"护城河",而不是在通用能力上和科技巨头肉搏。

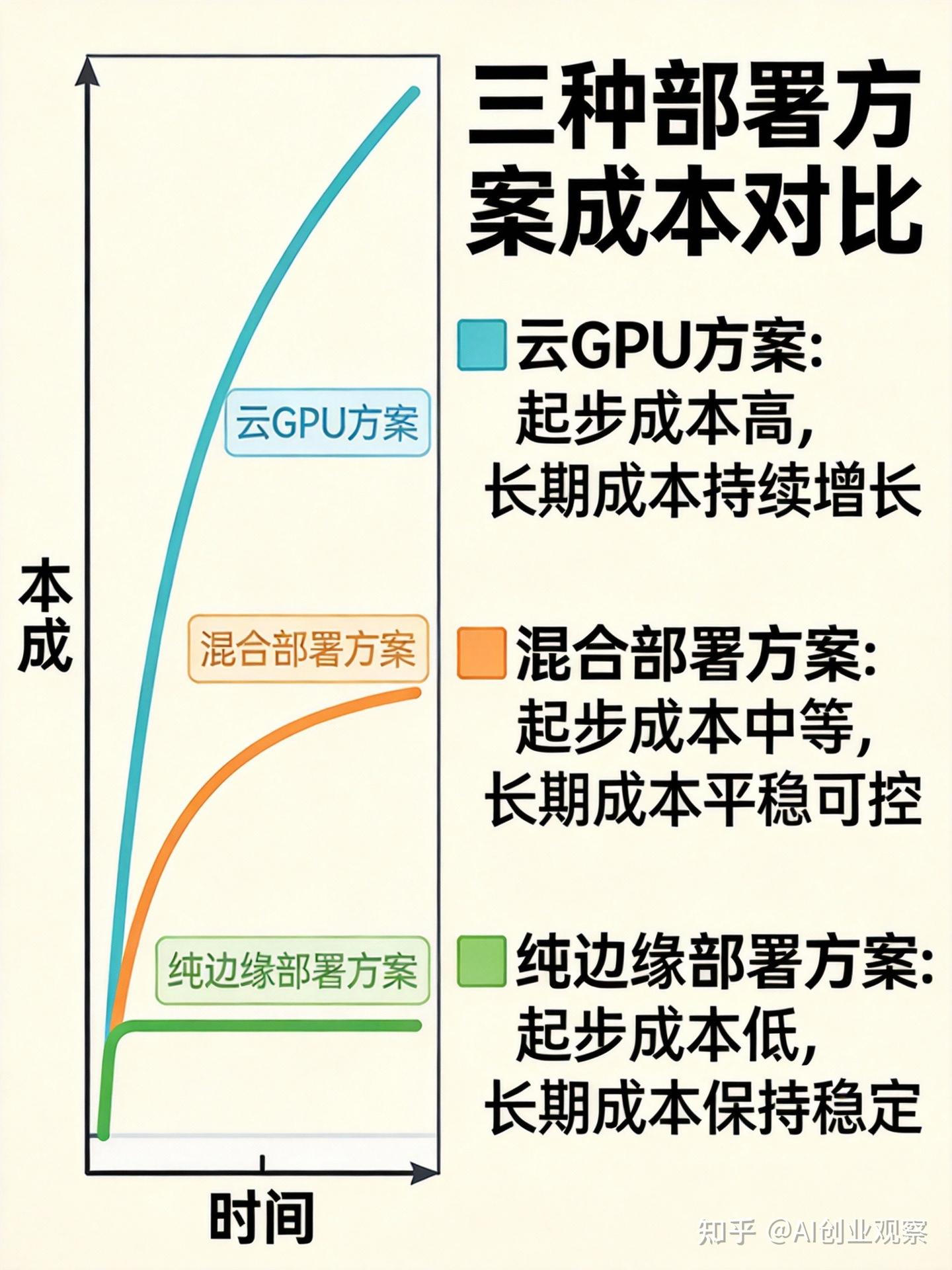

三、三种主流部署方案:哪一条是你的突围之路?

转向小模型策略,意味着你需要重新规划从云资源采购到部署架构的整体策略。我们分析了三种主流部署方案,帮你找到最适合自己的成本突围之路。

方案一:纯云GPU部署(适合快速验证,成本高)

适用场景:产品早期验证阶段,用户量较小,需要快速迭代

成本结构:

优势:

部署简单,几乎零运维

弹性伸缩,用多少付多少

快速上线,适合MVP验证

劣势:

长期成本不可控

依赖网络,离线场景无法使用

数据隐私风险

方案二:混合部署(云+边缘,平衡成本与性能)

适用场景:有一定用户量,需要兼顾成本和性能,部分场景需要离线能力

成本结构:

初始投入:中等(需要购买部分硬件)

月度成本:中等($1,000-$5,000/月)

边际成本:中低(新增用户成本递减)

优势:

成本可控,长期看更经济

部分场景可离线运行

用户体验更流畅

劣势:

需要一定的运维能力

部署复杂度增加

需要处理数据同步问题

方案三:纯边缘部署(适合大规模应用,成本最低)

适用场景:用户量大,对成本敏感,需要极致性能或离线能力

成本结构:

优势:

长期成本最低

离线运行,不依赖网络

数据完全本地化,隐私无忧

响应速度快

劣势:

初始投入较大

需要专业的运维团队

模型更新需要重新部署

四、如何选择:三个关键决策点

面对这三种方案,你需要根据自己公司的实际情况来选择。我建议从以下三个维度进行评估:

1. 你的用户规模和增长速度

用户量<10万,且增长缓慢:选择纯云部署,快速验证

用户量10万-100万,且稳定增长:选择混合部署,平衡成本

用户量>100万,或增长迅猛:考虑纯边缘部署,控制成本

2. 你的业务场景是否需要离线能力

完全在线场景(如SaaS服务):云部署或混合部署

部分离线场景(如移动应用):混合部署

完全离线场景(如工业设备):纯边缘部署

3. 你的团队能力结构

没有运维团队:云部署

有基础运维能力:混合部署

有专业运维团队:边缘部署

五、实战案例:一家垂直AI公司的转型之路

让我们看一个真实的转型案例。

某医疗AI公司,最初使用GPT-4 API为医院提供智能病历分析服务。每月API成本高达8万美元,但因为响应速度慢(平均3-5秒)、数据隐私问题,客户接受度不高。

2024年Q3,他们决定转向小模型策略:

选型:基于Llama-3-7B,使用医疗领域数据进行微调

部署:采用混合部署方案,医院内部署本地服务器

效果:

响应速度提升到<1秒

月度成本从8万美元降到1.5万美元(硬件+运维)

数据完全本地化,医院更放心

客户转化率提升3倍

这个案例告诉我们:在垂直领域,小模型+合适的部署方案,往往能比大模型创造更大的商业价值。

六、最后的思考:小模型不是终点,而是起点

小模型浪潮的本质,是AI行业从"通用大模型"时代走向"垂直专用模型"时代的必然结果。

对于初创公司来说,这或许是一个千载难逢的机会:你不需要在算力军备竞赛中和科技巨头硬碰硬,而是可以在你的垂直领域,用更小的模型、更低的成本、更精准的服务,构建你自己的商业护城河。

但请记住:小模型不是银弹。它依然需要你深入理解你的用户、你的场景、你的技术边界。

真正的机会,不在于模型大小,而在于你能用多大的勇气,在算力焦虑和商业现实之间,找到属于你的那条突围之路。

如果你正在为AI算力成本发愁,或者正在考虑转向小模型策略,欢迎在评论区分享你的经验和困惑。我们一起探讨,一起寻找答案。

下一步行动

基于我们与数十家 AI 初创公司共同梳理的经验,我们整理了一份《AI 初创公司 0 成本上云方案》。

这份方案能够提供一线云厂商官方的云资源,是一份足以支撑一个初创企业从 0 到 1 的技术能力包。包括云服务器、云数据库和百亿级别的 AI Token。

如需获取,可私信联系我们,或点击了解。

创业路上,我们与你同行!

本文基于2024年下半年至2025年初的行业实践整理,数据和案例均来自真实访谈。